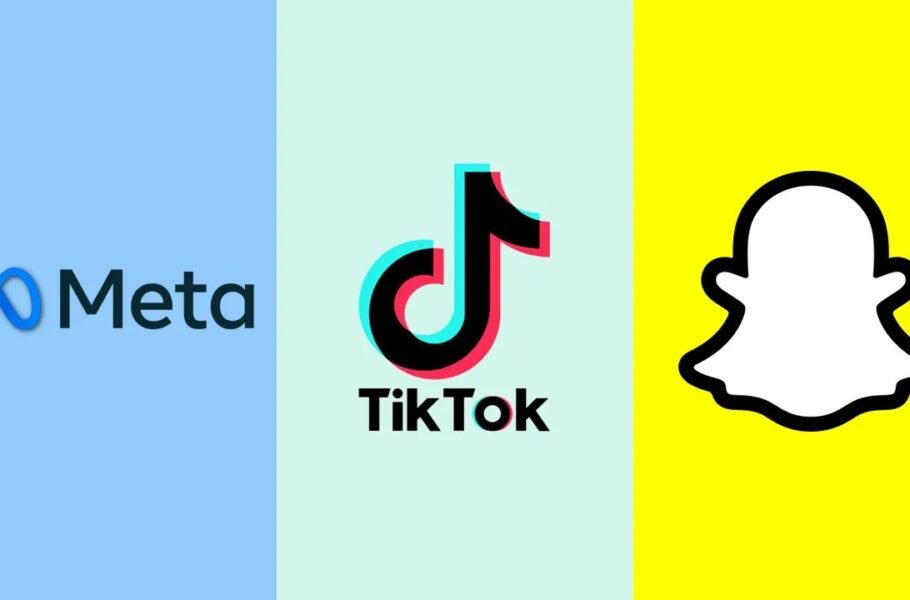

همکاری متا، تیک تاک و اسنپ چت برای شناسایی محتواهای مضر

6 ماه پیش ( 1403/6/27 )متا، اسنپ چت و تیک تاک با هم همکاری می کنند تا در طرحی به نام Thrive محتواهای مضر درباره خودکشی و خودآزاری را در پلتفرم هایشان تشخیص دهند. عملکرد این برنامه به این صورت است که اگر متا چنین محتواهای مضری در پلتفرم های خود شناسایی کرد، سیگنالی به دیگر شرکت ها می فرستد تا وجود این محتوا را در اپلیکیشن هایشان بررسی کنند.

براساس اعلام متا، «ائتلاف سلامت روان» برای ایجاد برنامه Thrive به شرکت های فناوری اجازه می دهد سیگنال هایی درباره تشخیص محتوای خودکشی یا خودآزاری به دیگر پلتفرم ها بفرستند تا از انتشار آن ها در پلتفرم های مختلف جلوگیری شود. متا دراین باره می گوید:

«مانند بسیاری از انواع مختلف محتوای مشکل ساز، محتوای خودکشی و خودآزاری به هیچ پلتفرمی محدود نیست… به همین دلیل با ائتلاف سلامت روان تلاش کردیم Thrive به وجود بیاید. این برنامه برای به اشتراک گذاشتن سیگنال های مربوط به نقض [قوانین درباره] محتوای خودکشی و خودآزاری است.»

نحوه عملکرد برنامه Thrive متا، اسنپ چت و تیک تاک

هنگامی که شرکتی مانند متا محتوای مضری را در اپلیکیشن های خود کشف می کند، هش (کد ناشناس مربوط به محتوای خودآزاری یا خودکشی) را با سایر شرکت های فناوری به اشتراک می گذارد، تا آن ها بتوانند پایگاه داده هایشان را برای جست وجوی همان محتوا بررسی کنند.

متا می گوید از آوریل تا ژوئن امسال (فروردین و خرداد)، بیش از 12 میلیون محتوای مربوط به خودکشی و خودآزاری در فیسبوک و اینستاگرام شناسایی کرده است. این شرکت اگرچه به کاربران اجازه می دهد درباره تجربیات خودکشی و خودآزاری خود صحبت کنند، وقتی این مطالب جنبه ترغیب دیگران به چنین کاری پیدا کند، محتوایی مضر شناسایی می شود.

یکی از مسائل دشوار تشخیص محتوای مضر در شبکه های اجتماعی این است که باید دائم تحت نظارت قرار بگیرند. هوش مصنوعی مطمئناً می تواند به برچسب گذاری خودکار این محتواهای مضر کمک کند اما بسیاری از این محتواها جزئیات ظریفی دارند که فقط انسان می تواند جنبه مضر آن ها را تشخیص دهد. اکنون شرکت های فناوری در برنامه Thrive گام مهمی برداشته اند تا فرایند پیچیده یافتن و پاکسازی این محتواها کمی آسان تر شود.

- رازهای موفقیت اپل

- مدیریت کارمندان تازه وارد؛ چالشی برای مدیران

- معمای بازاریابی برای محصولات دیجیتال

- مزایای تبلیغات محیطی در عصر دیجیتال

- تغییر و تحولات صنعت بازاریابی در سال 2023

- پرفروش ترین فیلم های سال 2023

- بازاریابی درونگرا (Inbound Marketing) چیست؟

- تعامل با مشتری در عصر دیجیتال: راهنمایی کاربردی

- چطور تبدیل به تولیدکننده محتوا شویم؟

- راهنمای قیمت گذاری دوره آموزش آنلاین

- درآمدزایی از پادکست؛ از افسانه تا واقعیت!

- اصول برندینگ برای فروشگاه های زنجیره ای

- شرکت های کوچک تر باید مدیریت ریسک را بپذیرند

- چگونه از سلامت روان کارکنان جدید حمایت کنیم

- هوش مصنوعی چطور مدیریت سئو را راحت می کند؟