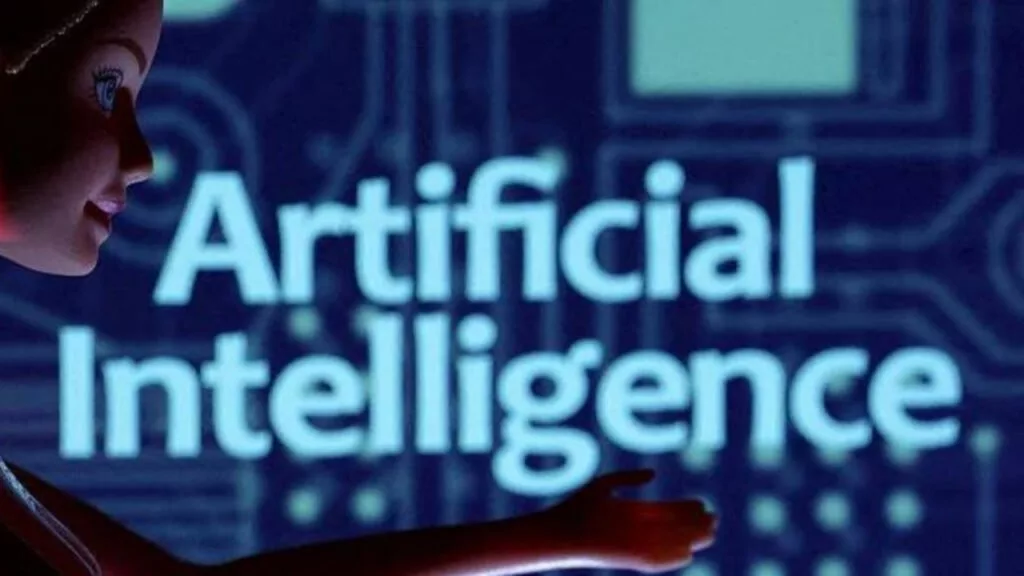

انتقاد مدیر OpenAI از لایحه ایمنی هوش مصنوعی کالیفرنیا

5 ماه پیش ( 1403/6/1 )«جیسون کوون»، مدیر ارشد استراتژی OpenAI در نامه ای با اشاره به یک لایحه ایمنی در حال بررسی در کالیفرنیا، گفته که تنظیم مقررات هوش مصنوعی باید به دولت فدرال سپرده شود. کوون می گوید که این لایحه ایمنی می تواند سرعت پیشرفت هوش مصنوعی را آهسته تر کند و باعث شود تا شرکت ها این ایالت را ترک کنند.

براساس گزارش ورج، در این نامه خطاب به سناتور ایالتی کالیفرنیا، «اسکات وینر» که قانون نوآوری ایمن برای مدل های هوش مصنوعی مرزی موسوم به «SB 1047» را پیشنهاد کرده، نوشته شده است:

«مجموعه ای از سیاست های هوش مصنوعی تنظیم شده توسط فدرال، به جای مجموعه ای از قوانین ایالتی، نوآوری را تقویت می کند و ایالات متحده را در مسیر رهبری توسعه استانداردهای جهانی قرار می دهد. در نتیجه، ما به دیگر آزمایشگاه های هوش مصنوعی، توسعه دهندگان، کارشناسان و اعضای هیئت کنگره کالیفرنیا در مخالفت محترمانه با SB 1047 می پیوندیم و از وجود فرصتی برای بیان برخی از نگرانی های اصلی خود استقبال می کنیم.»

لایحه پیشنهادی کالیفرنیا برای ایمنی هوش مصنوعی

وینر و سایر طرفداران این قانون می گویند که با SB 1047 می توان استانداردهایی را قبل از توسعه مدل های هوش مصنوعی قدرتمند ایجاد کرد.

همچنین آن ها می گویند که این قانون شرکت ها را به انجام برخی اقدامات پیشگیرانه مانند تست امنیت مدل های قبل از استقرار ملزم می کند، در آزمایشگاه های هوش مصنوعی از افشاگران محافظت می کند، به دادستان کل کالیفرنیا این اختیار را می دهد تا در صورت آسیب رساندن به مدل های هوش مصنوعی، اقدام قانونی انجام دهد و درنهایت خواستار ایجاد یک «خوشه رایانه ابری عمومی» به نام CalCompute می شود.

وینر در پاسخ به نامه مدیر ارشد OpenAI، اشاره می کند که الزامات پیشنهادی برای هر شرکتی که در کالیفرنیا تجارت می کند، بدون در نظر گرفتن این موضوع که مقر آن ها در این ایالت است یا نیست، اعمال می شود، بنابراین استدلال مطرح شده در نامه «معنا ندارد.» او می گوید:

«SB 1047 یک لایحه بسیار معقولانه است که از آزمایشگاه های هوش مصنوعی بزرگ می خواهد کاری را که قبلاً متعهد به انجام آن بوده اند، یعنی آزمایش مدل های بزرگ خود برای خطرات امنیتی فاجعه بار را انجام دهند.»

لایحه SB 1047 هم اکنون در انتظار رأی نهایی خود است تا به دفتر فرماندار کالیفرنیا، «گاوین نیوسام» ارسال شود.

- رازهای موفقیت اپل

- مدیریت کارمندان تازه وارد؛ چالشی برای مدیران

- معمای بازاریابی برای محصولات دیجیتال

- مزایای تبلیغات محیطی در عصر دیجیتال

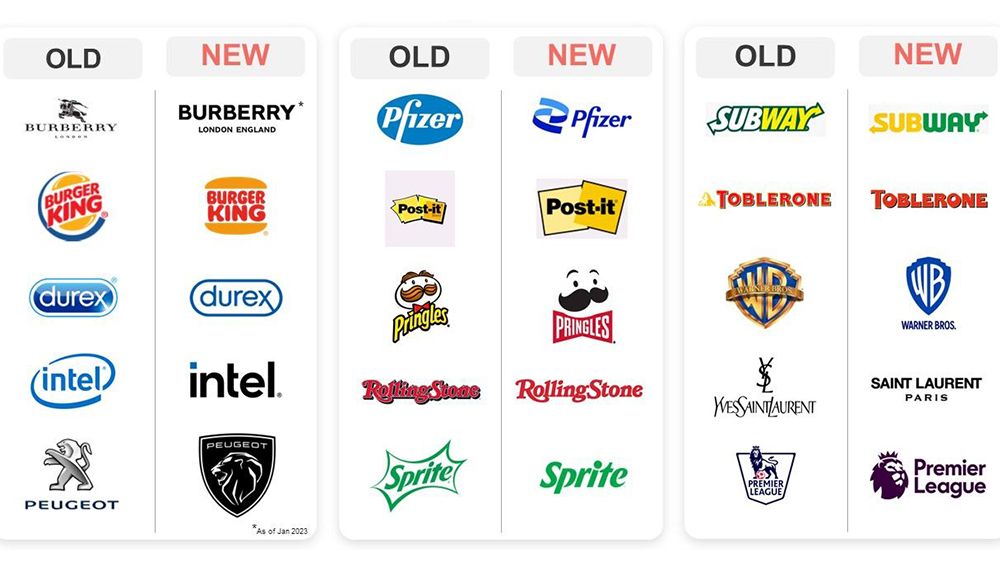

- تغییر و تحولات صنعت بازاریابی در سال 2023

- پرفروش ترین فیلم های سال 2023

- بازاریابی درونگرا (Inbound Marketing) چیست؟

- تعامل با مشتری در عصر دیجیتال: راهنمایی کاربردی

- چطور تبدیل به تولیدکننده محتوا شویم؟

- راهنمای قیمت گذاری دوره آموزش آنلاین

- درآمدزایی از پادکست؛ از افسانه تا واقعیت!

- اصول برندینگ برای فروشگاه های زنجیره ای

- شرکت های کوچک تر باید مدیریت ریسک را بپذیرند

- چگونه از سلامت روان کارکنان جدید حمایت کنیم

- هوش مصنوعی چطور مدیریت سئو را راحت می کند؟

سرویس های فرصت امروز

بیشتر بدانید

تبلیغات

- تبلیغات بنری : 09031706847 (واتس آپ)

- رپرتاژ و بک لینک: 09945612833